ビッグデータについていろいろ書いてきましたが、今後の企業の優位性について考えたことを纏めておこうと思います。

ビッグデータを取り巻くプレイヤー

ビッグデータに関連する職業として、データサイエンティストなどいろんな人たちが注目されています。シンプルに考えても、

- データを収集する人

- データを保持する人

- データを販売する人

がいそうです。

データを収集する人は、TwitterやFacebookなどプラットフォームを構成し活動履歴を収集するタイプもいますし、センサーなどからデータを収集するメーカーなどもいます。

データを保持する人は、データを収集する人と同じ場合もありますし、複数社からデータを統合して保持する場合もあります。Tポイントなんかが該当するでしょうか。

データを販売する人は、集められたデータを加工し分析したものを売ったりします。

一方で、少し古い調査結果ですが、ビッグデータを活用する上での問題点がどこにあるのか、というのが以下の記事で書かれていました。

ビッグデータ活用の取り組みが進んでいない理由として、「具体的に何に活用するかが明確でない(61%)」「投資対効果の説明が難しい(45%)」を課題としてあげている回答が多いことに加え、より具体的な課題として「担当者のスキル不足(45%)」「ビジネスとデータの両視点で検討できる人材の不足(36%)」「担当者の人数不足(32%)」「受け皿となる組織が存在しない(29%)」のように、ビッグデータ活用を推進できる体制が整っていないことが明らかになりました(図5、複数回答)。

約6割の企業がビッグデータの活用を組織的な検討課題と認識 一方、推進体制の未整備が活用の進まない要因に~ビッグデータの利活用に関する企業アンケート結果~ | 野村総合研究所(NRI)

いろいろ書いてありますが、データを収集したり加工することはあまり問題点ではなく、どちらかというと分析アプローチを発見することに難しさがあるようです。

価値の源泉は「ノウハウ」から「アイデア」、そして「データ」へ

「ビッグデータの正体」では、価値の源泉について以下のように書かれていました。

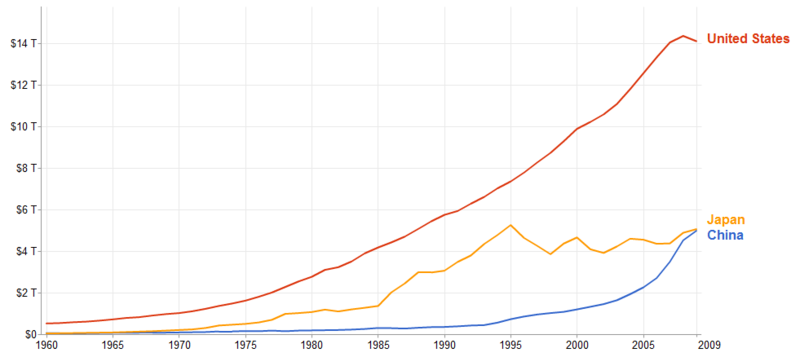

互いにライバル関係にある複数の自動車メーカーからデータを集め、価値を高めた情報を〝商品〟として提供する。自動車メーカー1社では、そこまでの価値を生み出せない。メーカー1社でデータを集められる車両数はせいぜい数百万。そのデータでも渋滞予測は可能だが、予測精度も低く、網羅的でもない。品質を上げるにはデータ量が必要だ。また、すでにノウハウからアイデアへと価値がシフトしていて、現在はデータへと移行しているからだ。

ビジネスの価値は、相対的に製造技術などのノウハウではなく、デザインや新しいアイデアの方が高まっています。サムスンが高い技術力で戦ってもAppleのブランドに打ち勝つことができない、というのが好例かと思います。

しかし、情報化社会が進み、情報処理技術が高度化して大量のデータを扱えるようになり、さらにセンサーなど社会にあふれている物事をデータとして取得できるようになると、データそのものの価値が上昇します。

「ビッグデータの正体」では、今はデータを活用するアイデアを持つ人が注目されているが、最終的にはデータへ移行するだろうと言っています。これはつまり、データを大量に集めようとすると、特定領域で独占状態になるからだと思います。

FacebookやTwitterが注目されるのは、それ以上に大量のソーシャルデータを保有しているサービスがないからです。COOKPADでも、それに勝るようなレシピサイトがないからです。ほぼデータを独占していると言ってよいでしょう。

つまり、ビジネス上有用と思われるデータを保有することが、もっとも競争性を獲得することができる、というのがビッグデータの世界です。

それにしても、ビッグデータの盛り上がりっぷりは、Googleトレンドをみてもすごいなーと思ってしまいますね。